Kako stroju objasniti ljudsku nesigurnost?

Istraživači razvijaju način da u sustave strojnog učenja ugrade i nesigurnost, jednu od najljudskijih karakteristika

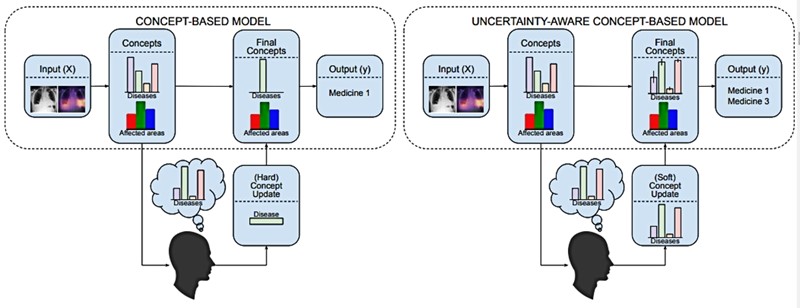

Ljudska pogreška i neizvjesnost koncepti su koje mnogi sustavi umjetne inteligencije ne uspijevaju shvatiti, osobito u sustavima u kojima čovjek daje povratnu informaciju modelu strojnog učenja. Mnogi od ovih sustava programirani su tako da pretpostavljaju da su ljudi uvijek sigurni i točni, ali donošenje odluka u stvarnom svijetu uključuje povremene pogreške i nesigurnost.

Povjerenje i pouzdanost

Istraživači Sveučilišta u Cambridgeu pokušavaju s Institutom Alan Turing, Princetonom i Google DeepMindom premostiti jaz između ljudskog ponašanja i strojnog učenja, tako da se neizvjesnost može potpunije objasniti u primjenama umjetne inteligencije tamo gdje ljudi i strojevi rade zajedno. To bi moglo smanjiti rizike te poboljšati povjerenje i pouzdanost, posebno tamo gdje je sigurnost ključna, na primjer u medicinskoj dijagnostici.

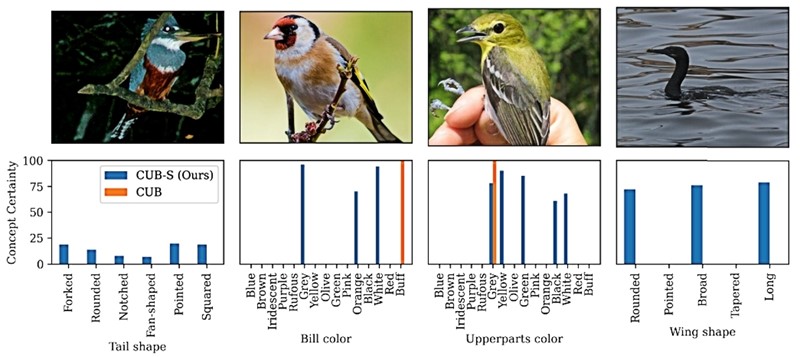

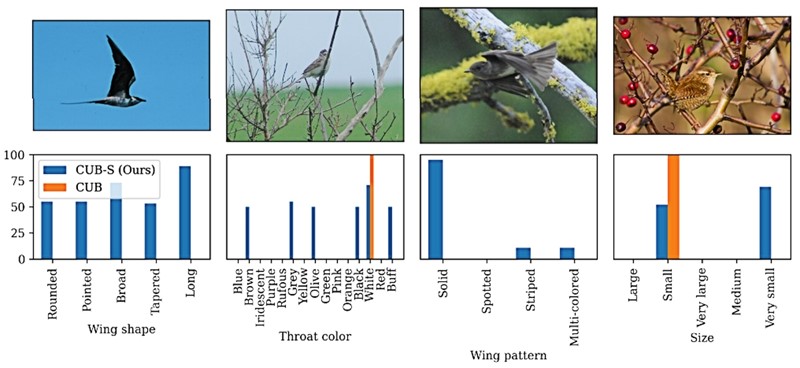

Istraživači su prilagodili dobro poznati skup podataka o klasifikaciji slika kako bi ljudi mogli dati povratne informacije i naznačiti svoju razinu nesigurnosti prilikom označavanja određene slike. Pokazalo se da obuka s nesigurnim oznakama može poboljšati performanse ovih sustava u rukovanju nesigurnim povratnim informacijama, sukus je istraživanja predstavljenog na AAAI/ACM konferenciji o umjetnoj inteligenciji, etici i društvu AIES 2023. u Montréalu.

Što kad ljudi nisu sigurni?

Human-in-the-loop (HITL) sustavi strojnog učenja koji omogućuju ljudske povratne informacije često se smatraju obećavajućim načinom za smanjenje rizika u postavkama u kojima se ne može osloniti na automatizirane modele da sami donose odluke. Ali što ako ljudi nisu sigurni?

"Nesigurnost je ključna u tome kako ljudi razmišljaju o svijetu, ali mnogi modeli umjetne inteligencije to ne uzimaju u obzir", kaže Katherine Collins s Cambridgeovog Odjela za inženjerstvo.

Ljudi stalno donose odluke na temelju ravnoteže vjerojatnosti, često bez stvarnog razmišljanja o tome. Većinu vremena – na primjer, ako mašemo nekome tko izgleda kao prijatelj, ali se ispostavi da je potpuni stranac – nema štete ako stvari pogrešno shvatimo. Međutim, ponekad nesigurnost nosi stvarne sigurnosne rizike.

Izazov neizvjesnosti

“Mnogi sustavi ljudske inteligencije pretpostavljaju da su ljudi uvijek sigurni u svoje odluke, što nije način na koji ljudi rade – svi mi griješimo”, objašnjava Collins.

"Iz desetljeća istraživanja ponašanja znamo da ljudi gotovo nikad nisu 100% sigurni, ali izazov je to uključiti u strojno učenje", objašnjavaju istraživači koji su identificirali nekoliko otvorenih izazova pri uključivanju ljudi u modele strojnog učenja.

"Neizvjesnost je oblik transparentnosti. Moramo shvatiti kad možemo vjerovati modelu, a kad čovjeku i zašto. S porastom upotrebe chatbota trebaju nam modeli koji bolje uključuju jezik mogućnosti, što može dovesti do prirodnijeg, sigurnijeg iskustva", kažu istraživači, svjesni da je njihov rad pokrenuo više pitanja nego što je dao odgovora.