Chatboti su prefini da bi sasvim zamijenili ljude

Istraživači razmatraju sposobnost umjetne inteligencije da oponaša ljude u područjima kao što su psihologija, političke znanosti, ekonomija i istraživanje tržišta

Generativni jezični modeli na prepad su osvojili svijet. Možda je najpoznatiji OpenAI-jev niz GPT modela koji pokreću ChatGPT chatbot. Ali druge velike tehnološke tvrtke, uključujući Google i Metu, ulažu resurse u vlastite modele. Obučeni na golemim količinama teksta, ovi modeli imaju nevjerojatnu sposobnost oponašanja verbalnog ljudskog ponašanja. Već su se koristili u pisanju računalnog koda, sažimanju pravnih dokumenata i pokretanju chatbota koji podučava studente ili provodi terapiju.

Moralne prosudbe

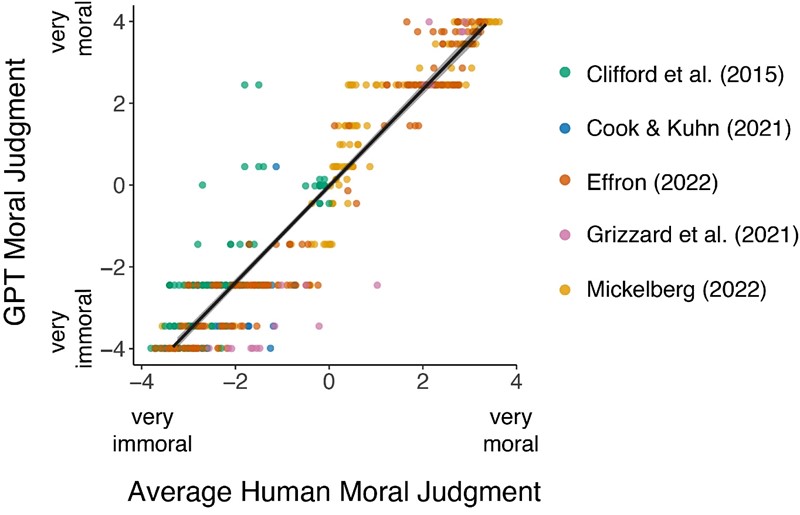

Socijalni psiholozi Sveučilišta Sjeverne Karoline u Chapel Hillu i računalni znanstvenici Allenovog instituta za umjetnu inteligenciju odlučili su istražiti mogu li razviti sustav umjetne inteligencije koji donosi moralne prosudbe poput ljudi. Za svoje su istraživanje iskoristili OpenAI GPT-3.5 i o rezultatima izvijestili u časopisu Trends in Cognitive Science.

Umjetna inteligencija je procijenila etičnost 464 različitih scenarija, od prodaje kuće radi financiranja programa za potrebite do afere sa suprugom vašeg najboljeg prijatelja. Pokazalo se da su odgovori sustava bili gotovo identični ljudskim odgovorima, s koeficijentom korelacije od 0,95.

Studije ponašanja

Istraživači sad razmatraju sposobnost umjetne inteligencije da oponaša ljude u područjima kao što su psihologija, političke znanosti, ekonomija i istraživanje tržišta.

Nitko još ne sugerira da chatbotovi mogu u potpunosti zamijeniti ljude u studijama ponašanja. Ali mogu djelovati kao zgodna zamjena u pilot studijama i eksperimentima, štedeći pritom i vrijeme i novac. Jezični modeli također mogu pomoći u eksperimentima koji bi bili previše nepraktični, neetični ili čak opasni za izvođenje s ljudima.

"Silicijski uzorci"

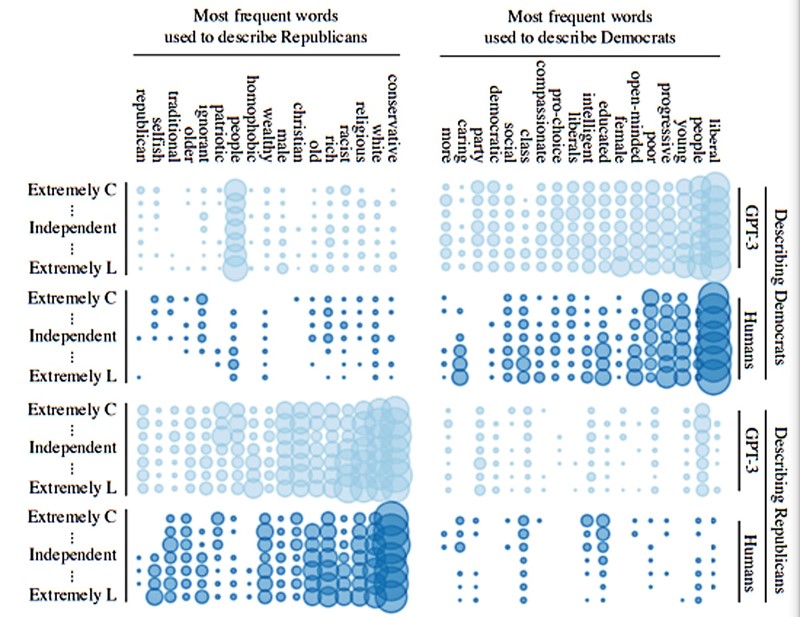

Prošle godine istraživači mormonskog Sveučilišta Brigham Young stvorili su "silicijske uzorke" (silicon samples), odnosno simulacije ljudskih uzoraka. U jednoj studiji dali su GPT-3 modelu informacije o dobi, spolu, rasi, razini obrazovanja i političkom opredjeljenju. A kad bi istraživači izostavili jednu od ovih varijabli, odgovori modela umnogome su se podudarali s onima iz ankete među biračima. Štoviše, model bi izbacio politički govor koji je odgovarao dodijeljenoj stranačkoj pripadnosti. Ovakve virtualne ispitanike sad analitičari žele koristiti za testiranje pitanja u online anketama kako bi ih učinili učinkovitijima.

Modeli s crtama ličnosti

Jezični modeli mogu usvojiti i arhetipove ličnosti. U MIT-ovoj studiji istraživači su u GPT-3.5 usadili karakteristike stotina osoba s različitim kombinacijama osobina ličnosti: introvertirane, antagonističke, savjesne, neurotične, nesklone stjecanju novih iskustava...

Model je za svaku osobu ispunio standardni test osobnosti i napisao 800 riječi dugačku priču iz djetinjstva koja je zatim analizirana na psiholingvističke značajke povezane s osobinama ličnosti. Pokazalo se kako su modeli poslušno iskazivali dodijeljene osobnosti, i na testu i u pričama. To bi istraživačima moglo pomoći da, na primjer, testiraju kako bi se ljudi s različitim osobnostima ponašali na različitim poslovima.

Modeli za istraživanje tržišta

Nedavna studija Harvardove poslovne škole otkrila je da GPT-3.5 pokazuje realno ponašanje potrošača. Na pitanje bi li kupio prijenosno računalo po različitim cijenama, model je bio manje osjetljiv na cijenu kad mu je rečeno da su mu godišnja primanja 120.000 dolara, a ne 50.000 dolara.

Više je volio bilo koju marku paste za zube koju je prethodno kupio, a manje bi platio jogurt ako ga već ima kod kuće. Također je rekao da je spreman platiti više za pastu za zube s fluorom ili dezodorans bez aluminija.

Ugledni klijenti

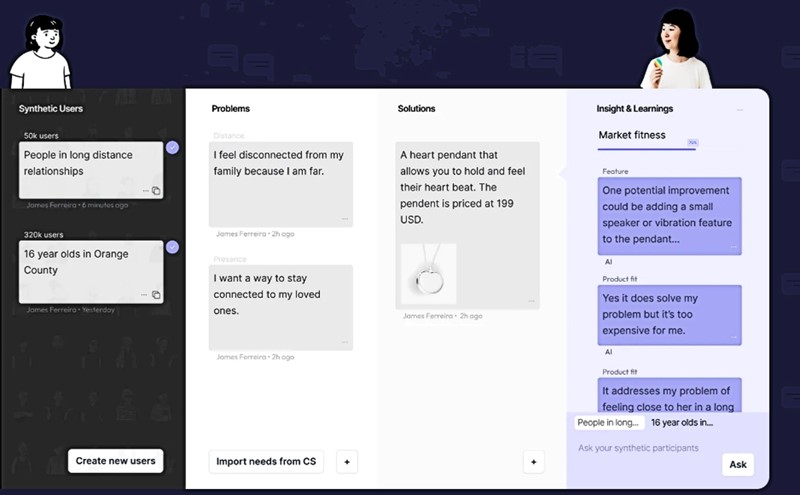

Startup Synthetic Users koristi OpenAI modele u kojima klijenti, uključujući Google, IBM i Apple, mogu opisati tip osobe koju žele anketirati i postaviti im pitanja o njihovim potrebama, željama i osjećajima o proizvodu kao što je nova web stranica ili nosivi uređaj.

Sustav tvrtke generira sintetičke intervjue za koje suosnivač Kwame Ferreira kaže da su "beskonačno bogatiji" i korisniji od "blagih" povratnih informacija koje tvrtke dobivaju kad anketiraju stvarne ljude.

Proučavanje ponašanja

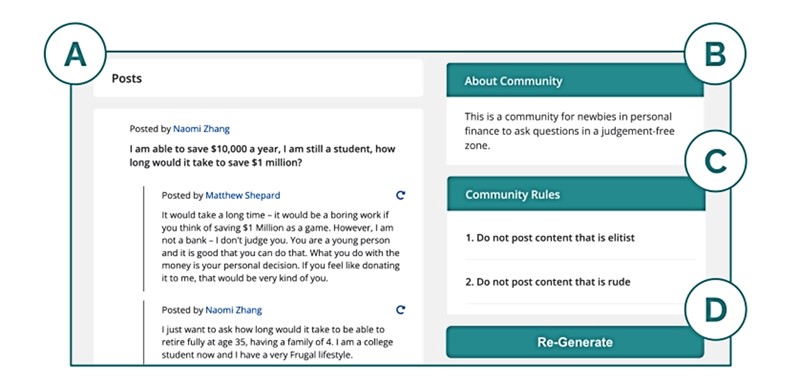

Chatbotovi se mogu suprotstaviti jedni drugima kako bi tako proučile složenije ljudske interakcije. Istraživači Googlea i Sveučilišta Stanford i Googlea razvili su tako "društvene simulakrume" (social simulacra) za proučavanje ponašanja korisnika na platformama kao što su Facebook i Reddit.

Istraživači su popunili platformu SimReddit s GPT ekvivalentom 1000 različitih korisnika. Ljudima je na kraju bilo teško razlikovati rasprave od stvarnih, a dizajneri platforme smatrali su alat korisnim za stvaranje pravila i moderiranje.

Generativni agenti

Ove su godine izradili i sveobuhvatniju simulaciju popunjenu "generativnim agentima". Likovi su dobili sposobnost pamćenja iskustava, razmišljanja o njima te stvaranja i izvršavanja planova.

Pojavilo se i organizirano ponašanje: istraživači su jednom agentu dali ideju za zabavu za Valentinovo, nakon čega su se svi agenti koordinirali kako bi je i organizirali. Istraživači vjeruju kako bi se virtualni svijet mogao iskoristiti za proučavanje učinka ekonomske politike prije nego što se ona nametne stvarnim ljudima.

Nesavršene kopije ljudi

Unatoč svim prividnim mogućnostima, jezični modeli ipak nisu savršena ljudska ogledala. Nedavna studija otkrila je tako da je i GPT-3.5, poput ljudi, sklon precijeniti koliko su njegova mišljenja raširena u općoj populaciji, što je pristranost poznata kao efekt lažnog konsenzusa (false consensus effect). Ali za razliku od ljudi, model je pokazao malo oklijevanja u preuzimanju rizika i iskušavanju sudbine.

Želimo li da umjetna inteligencija vjerno oponaša ljude, ona bi trebala fizički komunicirati sa svijetom, smatraju neki znanstvenici poput Marcela Binza s Instituta Max Planck za biološku kibernetiku; teško je naime pasivnim čitanjem naučiti sve nijanse inteligentnog ponašanja.

UI će brzo napredovati i vjerojatno ćemo za nekoliko godina imati sustav koji se jednostavno može staviti u bilo koji eksperiment i čije ponašanje nećemo razlikovati od ljudskog, vjeruje Binz. No, da bi modeli postali ljudskiji trebat će biti manje sigurni i manje politički korektni jer "pravi ljudi nisu uvijek dobri. Pravi ljudi govore i rasističke, seksističke stvari".