Napredniji AI modeli češće haluciniraju

Što je model napredniji, veća je vjerojatnost da će generirati netočne informacije, barem u sadašnjoj generaciji tehnologije, zaključak je internog testa kompanije OpenAI

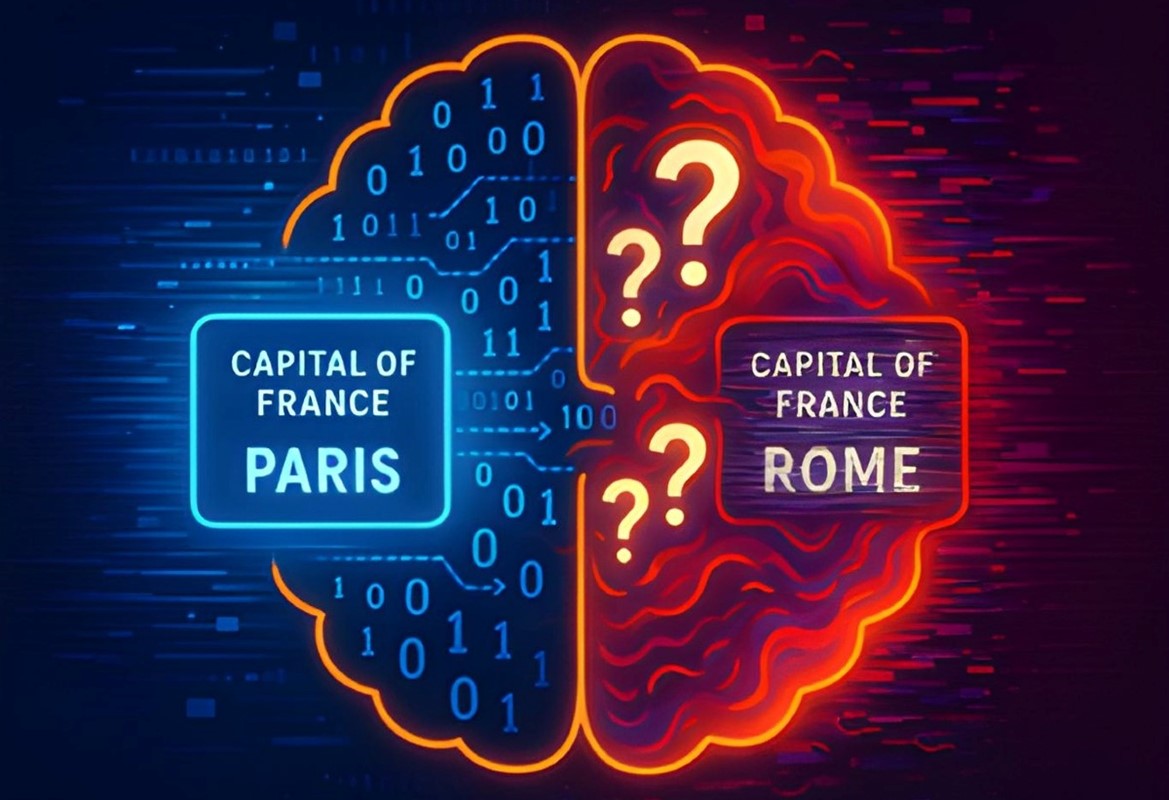

Najnoviji AI modeli OpenAI o3 i o4-mini postali su još snažniji i sposobniji, ali istovremeno i skloniji "halucinacijama", odnosno generiranju netočnih ili izmišljenih informacija. Ovaj fenomen detaljno je analiziran u službenom dokumentu "OpenAI o3 and o4-mini System Card".

Prema internim testovima, model o3 halucinira u 33 % slučajeva, dok o4-mini to čini u čak 48 % slučajeva, prema tvrtkinoj PersonQA evaluaciji koja mjeri pojavu halucinacija na temelju javno dostupnih činjenica. To je znatno više od prethodnika o1, koji je imao stopu halucinacija od 16 %. Paradoksalno, o3 istovremeno daje i više točnih odgovora, ali i više pogrešaka. To upućuje na to da je model skloniji tvrdnjama, bilo točnim ili netočnim, što pak pojačava rizik od širenja lažnih informacija.

Veliki izazov

OpenAI ističe da ovi modeli koriste najsuvremenije metode zaključivanja i mogu koristiti razne alate poput pretraživanja weba, analize slika, pokretanja Python koda i drugih automatizacija, što im omogućuje rješavanje složenih zadataka iz matematike, programiranja i znanosti. Iako su poboljšali sposobnost praćenja uputa i davanja korisnih, provjerljivih odgovora, nagli porast halucinacija je veliki izazov za pouzdanost i sigurnost sustava.

OpenAI ističe potrebu za daljnjim istraživanjem uzroka ovog fenomena i smanjivanjem rizika, ali trenutačno je osnovni zaključak: što je model napredniji, veća je vjerojatnost da će generirati netočne informacije, barem u sadašnjoj generaciji tehnologije.