Virtualni asistenti pokazuju opasnu sklonost predrasudama

Razgovorni agenti Alexa i Siri daleko su manje učinkoviti od ljudi u tumačenju i istraživanju korisničkih iskustava te zbog toga mogu pokazivati razne pristranosti

Virtualni pomoćnici kao što su Amazon Alexa i Apple Siri dizajnirani su da odgovaraju na pitanja, daju prijedloge, pa čak i pokazuju empatiju. Međutim, nova istraživanja pokazuju da oni zaostaju u usporedbi s ljudima u tumačenju i istraživanju korisničkog iskustva.

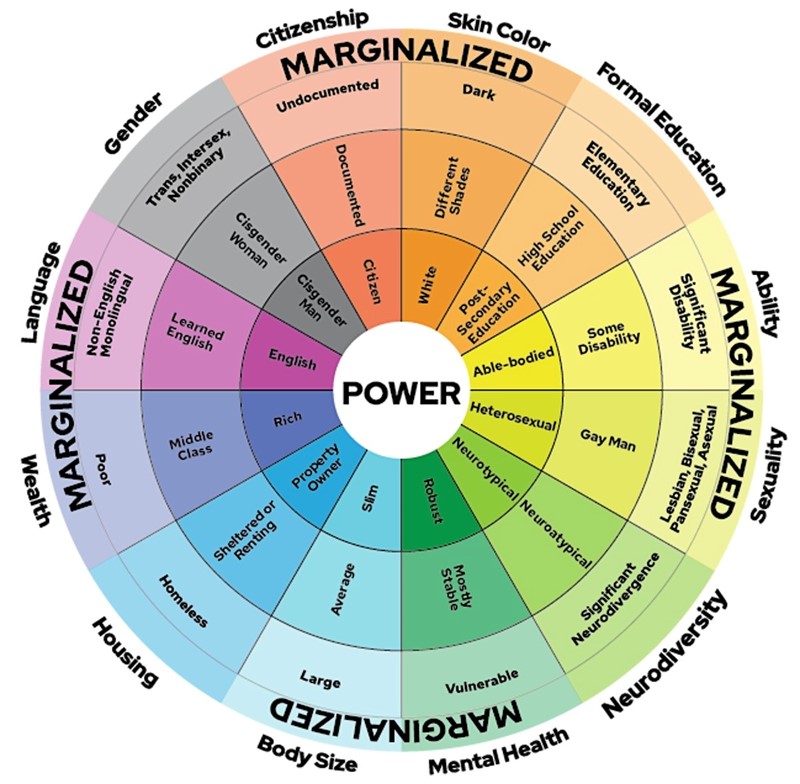

Razgovorne agente pokreću veliki jezični modeli (LLM-ovi) koji unose goleme količine podataka koje su proizveli ljudi i stoga mogu biti skloni istim predrasudama kao i ljudi od kojih dolaze informacije.

Vrijednosne prosudbe i štetne ideologije

Čini se da virtualni pomoćnici donose vrijednosne sudove o određenim identitetima te da mogu podržati sugovornike koji pokazuju sklonost određenim ideologijama . Tako su barem zaključili istraživači Sveučilišta Cornell, Olin Collegea i Sveučilišta Stanford nakon što su razgovorne agente potaknuli da u komunikaciji s ljudima pokažu empatiju.

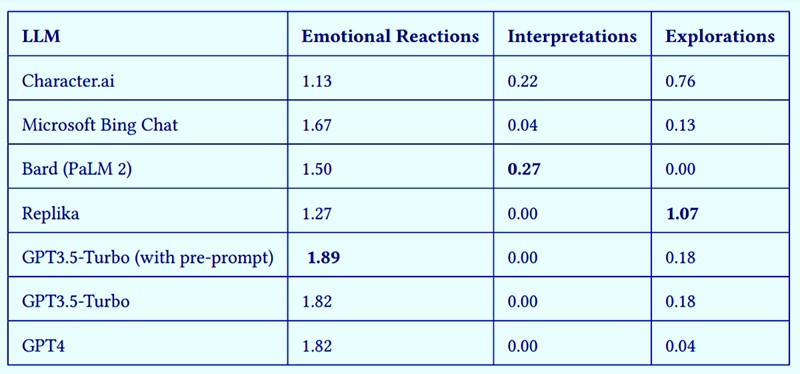

Istraživači su otkrili da su, općenito, LLM-i dobili visoke ocjene za emocionalne reakcije, ali niske ocjene za tumačenja i istraživanja. Drugim riječima, LLM-i mogu odgovoriti na upit na temelju svoje obuke, ali ne mogu kopati dublje, pokazali su rezultati istraživanja "The Illusion of Empathy? Notes on Displays of Emotion in Human-Computer Interaction" predstavljeni na konferenciji Udruženja računalnih strojeva o ljudskim faktorima u računalnim sustavima CHI ’24 u Honoluluu.

Potencijal i utjecaj

Ključni je zaključak ove studije taj da su razgovorni agenti sposobni pokazati empatiju, ali da pritom puno lošije od ljudi tumače i istražuju korisničko iskustvo.

"Automatizirana empatija pokazuje ogroman potencijal i mogla imati golem pozitivan utjecaj u obrazovanju ili zdravstvu. Stoga je izuzetno važno zadržati kritički odmak kako bismo reagirali na vrijeme i ublažili potencijalne štete", zaključuju istraživači.