Trening generativne AI: Nvidia najbrža, Intel blizu, Google zaostaje

Više od 200 rezultata koja je dostavilo 19 tvrtki i institucija pokazalo je 2,8 puta veći učinak u proteklih pet mjeseci i 49 puta veći otkako je prije pet godina pokrenut MLPerf tgest

Vodeći javni apple-to-apple test sposobnosti računalnih sustava da strojnim učenjem treniraju neuronske mreže ušao u eru generativne umjetne inteligencije. Nakon što je ranije ove godine MLPerf uveo test za obuku velikih jezičnih modela (LLM), posebno GPT-3, ovaj mjesec je dodao i test generatora teksta u sliku Stable Diffusion. Nova mjerila preuzela su računala koja pokreću Intel i Nvidia, a nastavljena je i bitka na treningu GPT-3 u koju se priključio i Google. Svi rezultati javno su dostupni i objavljuje ih ML Commons.

Moćni sustavi

Sva tri igrača - Nvidia, Intel i Google - tom su zadatku posvetila svoje moćne sustave, uključujući dosad najveće testirano Nvidijino superračunalo s 10.000 GPU. Ta je veličina neophodna u generativnoj umjetnoj inteligenciji jer čak bi i najvećem Nvidijinom sustavu trebalo osam dana rada da u potpunosti završi svoj LLM posao.

Na kraju je 19 tvrtki i institucija dostavilo više od 200 rezultata koji su pokazali 2,8 puta veći učinak u proteklih pet mjeseci i 49 puta veći otkako je prije pet godina pokrenut MLPerf.

Dominacija Nvidije

Nvidia je nastavila dominirati MLPerf mjerilima sa sustavima napravljenim od H100 GPU-a. Pažnju privlače rezultati njihovog Eosa, novog AI superračunala s 10.752 GPU-a koji je posao obavio za nešto manje od četiri minute.

Microsoftova platforma za računalstvo u oblaku Azure bila je iza Eosa samo nekoliko sekundi. Azure pokreće OpenAI-jev ChatGPT i GitHubovov pomoćnik za kodiranje CoPilot koji koristi više od 37.000 kompanija, među kojima i svaka treća najveća s liste Fortune 500.

Trostruko povećanje

Eosovi GPU-ovi sposobni su za ukupno 42,6 exaflopsa u sekundi i povezani su Nvidijinim Quantum-2 Infinibandom koji prenose 1,1 milijun milijardi bajtova u sekundi. Eos utrostručuje broj H100 GPU-ova koji su povezani u jedan stroj. To trostruko povećanje postiglo je poboljšanje performansi od 2,8 puta, odnosno učinkovitost skaliranja od 93 posto. Učinkovito skaliranje ključno je za kontinuirano poboljšanje generativne umjetne inteligencije, koja se udeseterostručuje svake godine.

GPT-3 mjerilo kojim se Eos pozabavio nije potpuna obuka GPT-3 jer je MLPerf želio da bude na dohvat ruke mnogim tvrtkama. Umjesto toga, uključuje uvježbavanje sustava do određene kontrolne točke koja dokazuje da bi uvježbavanje postiglo potrebnu točnost uz dovoljno vremena. A ti treninzi zahtijevaju vrijeme. Ekstrapolacija Eosove četiri minute znači da bi bilo potrebno osam dana da se dovrši obuka. Računalu razumnije veličine kao što je 512 H100s bila bi potrebna četiri mjeseca.

Intel hvata priključak

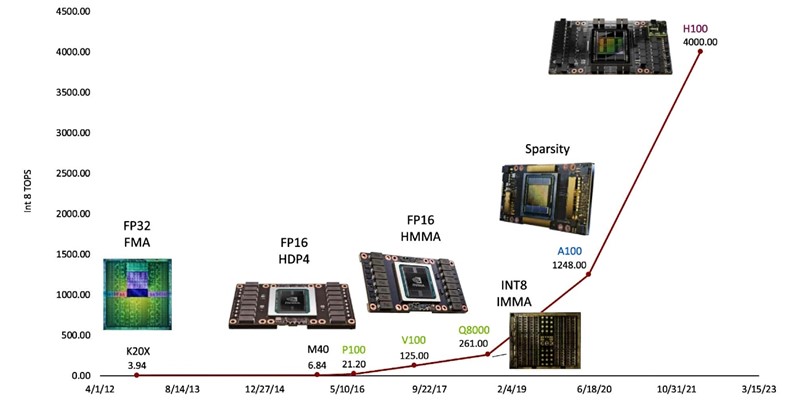

Intel je dostavio rezultate za sustave koji koriste akceleratorski čip Gaudi 2, oslanjajući se pritom samo na četvrtu generaciju Xeon CPU-a. Velika promjena u odnosu na prošli set referentnih vrijednosti za obuku bila je ta što je tvrtka iskoristila mogućnosti 8-bitnog pomičnog zareza (FP8), zaslužnog za većinu poboljšanja performansi GPU-a u posljednjih 10 godina, kako piše IEEE Spectrum.

Upotreba FP8 u dijelovima GPT-3 i drugim transformatorskim neuronskim mrežama u kojima njihova niska preciznost neće utjecati na točnost već je pokazala svoju vrijednost u Nvidijinim rezultatima za H100, a sada i kod Intelovog Gaudi 2 koji se pokazao triput bržim od Googleovog TPUv5e.

Fino podešavanje

Gaudi 2 je znatno jeftiniji od H100 i ima bolji odnos uloženog i dobivenog, kažu u Intelu koji puno nade polaže u sljedeću generaciju svog akceleratorskog čipa Gaudi 3. Taj će čip početi masovno proizvoditi sljedeće godine i bit će napravljen korištenjem istog procesa izrade poluvodiča kao Nvidia H100.

Intel je dostavio i rezultate za sustave koji se temelje samo na CPU-ima, ponovno pokazujući vremena obuke za nekoliko referentnih vrijednosti. Podaci pokazuju da Xeon sustav s četiri čvora, čiji čipovi uključuju AMX matrični motor, može fino podesiti generator slike Stable Diffusion za manje od pet minuta. Fino podešavanje koristi već uvježbanu neuronsku mrežu i specijalizira je za određeni zadatak.