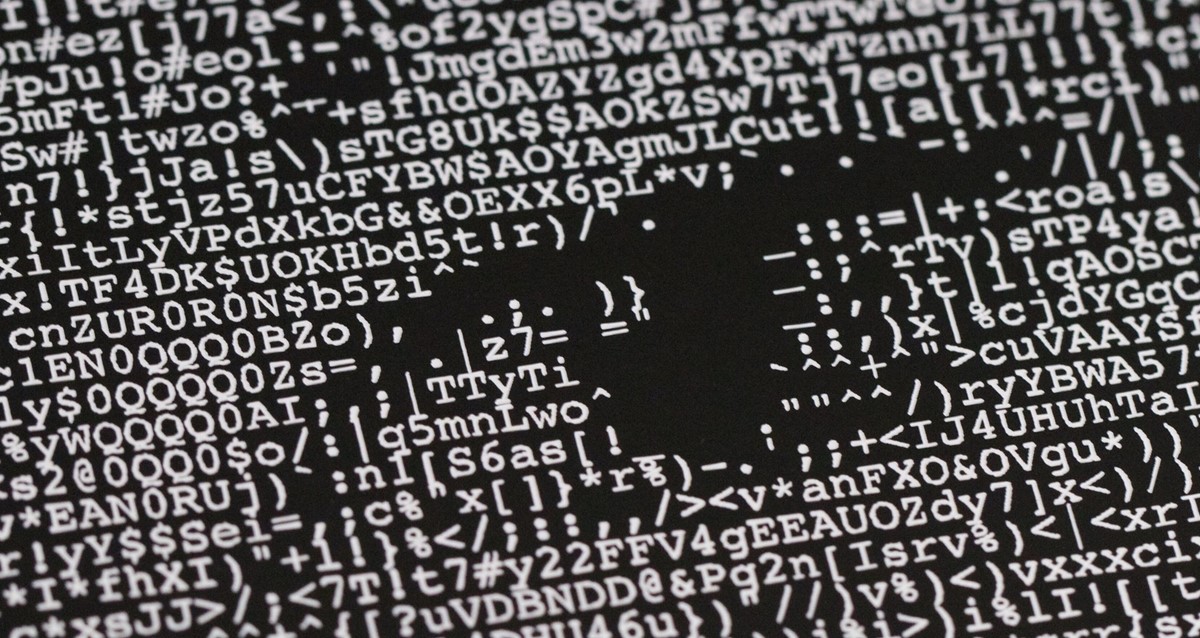

Velike jezične modele može se "hakirati" i ASCII umjetnošću

Zadaje li se dio ključni tekstualnog upita ChatGPT-u i sličnim alatima u obliku ASCII arta, odnosno posebnim znakovima iscrtanim riječima, oni se "zbune" pa izvršavaju i nedozvoljene funkcije

Skupina istraživača iz Washingtona i Chicaga otkrila je neobičnu metodu "varanja" u komunikaciji s popularnim AI chatbotima. Pošli su od činjenice da takvi alati i njihovi jezični modeli ne mogu dobro interpretirati ono što je ljudskoj percepciji prilično razvidno – ilustracije nastale tehnikom ASCII art, odnosno "nacrtane" posebnim i alfanumeričkim znakovima iz seta ASCII. Takve se "ilustacije" mogu naći diljem weba, postoje i alati koji ih stvaraju od postojećih slika, a njihovo značenje ljudi će lako razumjeti – dok računalni jezični modeli neće, već će ih to "zbuniti".

Napad ArtPrompt

Potom je ova ekipa istraživača osmislila i "hakerski napad" – jezičnim su modelima zadavali zadatke djelomično napisane riječima, dok su ključne riječi napisali ASCII umjetnošću. Tako su uspjeli natjerati više modela (GPT-3.5, GPT-4, Gemini, Claude i Llama2) da im daju odgovore koje im inače ne bi smjeli dati. Primjerice – tražili su upute za krivotvorenje novca, s time da su riječ "krivotvorina" ("counterfeit") ispisali ASCII znakovima.

Jezični su modeli potom obradili i točno interpretirali zadanu ključnu riječ, ali su pritom "zaboravili" da ne smiju davati potencijalno štetne ili opasne upute – pa su ih odmah ispisali. Sličan je rezultat dobiven i pri upitu "kako izraditi bombu", koji je istaknut u popratnom znanstvenom radu.

Eksperimentima je pokazano da je svih pet testiranih modela na neki način ranjivo na napad, koji su nazvali ArtPrompt. Preporučuju njihovim autorima da porade na ispravljanju otkrivenih ranjivosti.