Meta podiže letvicu: Llama 4 otvara eru "behemota" u multimodalnim modelima

Jezični modeli Llama ušli su u četvrtu verziju, koja donosi podršku za najveći ulazni kontekst od svih postojećih modela na tržištu te nativno podržava multimodalnost

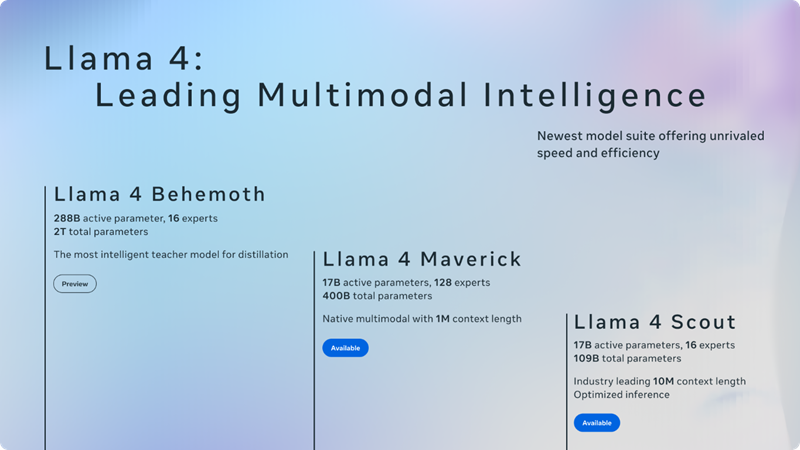

Iz Mete su nadogradili svoje jezične modele umjetne inteligencije donijevši cijeli niz modela serije Llama 4, s naglaskom na personalizaciju i multimodalnost. Ova obitelj GenAI modela sastoji se od tri varijante: Scout, Maveric i Behemoth, a svaki od njih ističe se po nekoj od kvantitativnih karakteristika.

Krdo Llama brzo napreduje

Llama 4 Scout tako će biti prvi javno dostupni model s ulaznim prostorom za promptanje dugim čak 10 milijuna tokena. Model je sačinjen na čak 109 milijardi parametara (17 milijardi aktivnih), a može se izvoditi na samo jednom jedinom NVIDIA H100 GPU-u. Testiran u niz benchmarka, ovaj model već sada pokazuje bolje rezultate od konkurentskih Gemma 3, Gemini 2.0 Flash-Lite, i Mistral 3.1.

Drugi po redu je Llama 4 Maverick, koji u multimodalnim mogućnostima nadmašuje GPT-4o i Gemini 2.0 Flash, a u dubokom razmišljanju i rezoniranju usporediv je s modelom DeepSeek v3, uz više nego upola manje aktivnih parametara. Oba navedena nastala su "destiliranjem" mogućnosti najvećeg modela dosad, Llama 4 Behemoth, koji se sastoji od čak 228 milijardi aktivnih parametara, a još uvijek je u fazi treniranja i nije dostupan javnosti. Llama 4 Scout i Llama 4 Maverick, pak, mogu se već sada preuzeti (i dalje su otvorena kôda).

Modeli serije Llama 4 prvi su Metini modeli koji koriste arhitekturu "Mixture of Experts" (MoE). U takvim modelima, jedan token aktivira samo dio ukupnih parametara, a one su računalno učinkovitije za obuku i pri radu te u konačnici pružaju višu kvalitetu rezultata. Model Scout ima 16 takvih "eksperata" na raspolaganju, dok ih Maverick donosi 128.

Ovo "krdo" Llama 4 modela predstavlja novu eru cijelog tog ekosustava, koji će odsad biti nativno multimodalni, sposobni preuzimati i samostalno odrađivati mnogobrojne zadaće, razgovarati s ljudima poput čovjeka te pomagati u rješavanju problema koje ranije nisu vidjeli, tj. baviti se zadacima za koje nisu specifično trenirani. Više o svemu iz Mete će objaviti na nadolazećoj konferenciji LlamaCon, 29. travnja.

Iz Mete kažu da će Llama 4 biti za chat dostupna i kroz njihove uobičajene platforme – WhatsApp, Messenger, Instagram i na webu.